고정 헤더 영역

상세 컨텐츠

본문

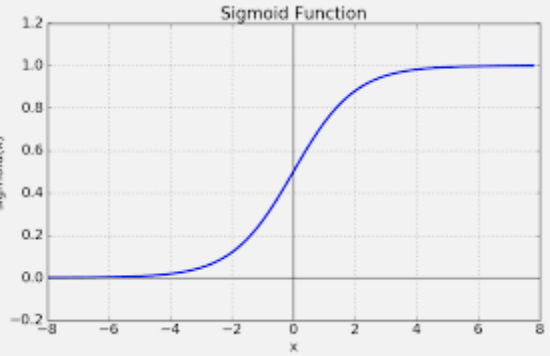

# Sigmoid 함수 :

- 1. Softmax 함수는 실수 전체를 정의역으로 가지며, 값은 0~1까지의 범위를 가진다.

=> 반환값을 확률로 볼 수 있다.

- 2. 실수 전체 범위에서 미분가능

- 3. 0에서 1로 바뀌는 부분 ( x=0)의 기울기가 가파르다는 장점

- 3. 인공 뉴런의 활성화 함수로 사용되어왔다. 이에서 파생된 tanh/arctan과 같은 함수가 여러가지 있다.

- 4. 딥러닝에서는 노드 임계값을 넘을 때만 출력하는 활성함수로 이용.

- 5. 미분 결과가 간결하고, 사용하기 쉽지만, 마이너스 값을 0에 가깝게 표현하기에 vanishing gradient문제의 원인이 됨

# Sigmoid의 vanishing gradient :

- 왜 Sigmoid함수가 기울기 손실(Vanishing Gradient)의 범인일까???

=> sigmoid함수를 미분한 값은 0~0.25의 값을 가지는데, Chain-Rule을 따라 sigmoid함수의 미분값을 연쇄적으로 곱해 입력층에 가까워질수록 값은 점점 작아질 수 밖에 없다. layer가 깊을수록 기울기 소실이 커지게 되는 것이다.

# 이를 해결하기 위해 나온 활성함수 ReLu(Rectified Linear Unit) :

장점

- 1. 다른 활성화 함수보다 학습이 빠름

- 2. 기울기 소실 문제가 발생하지 않는다.

- 3. Vanishing gradient문제 X

단점

- 1. 음수값이 입력되면 0을 반환

- 2. 입력값이 음수인 경우 기울기가 0이 되어 가중치 업데이트가 안되는 Dying ReLu현상 일어날 수 있다.

- 3. x=0에서 미분이 안 됨

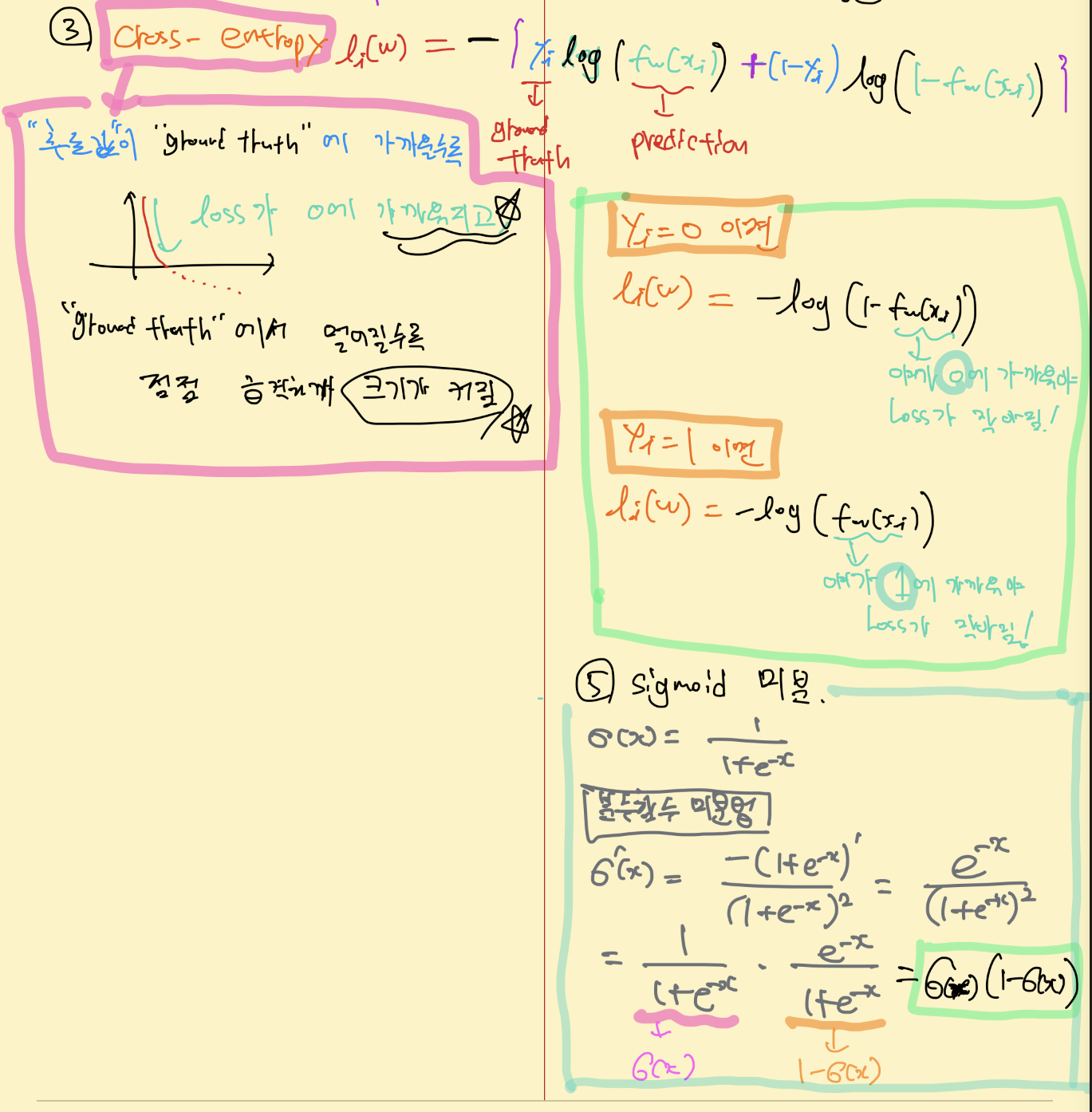

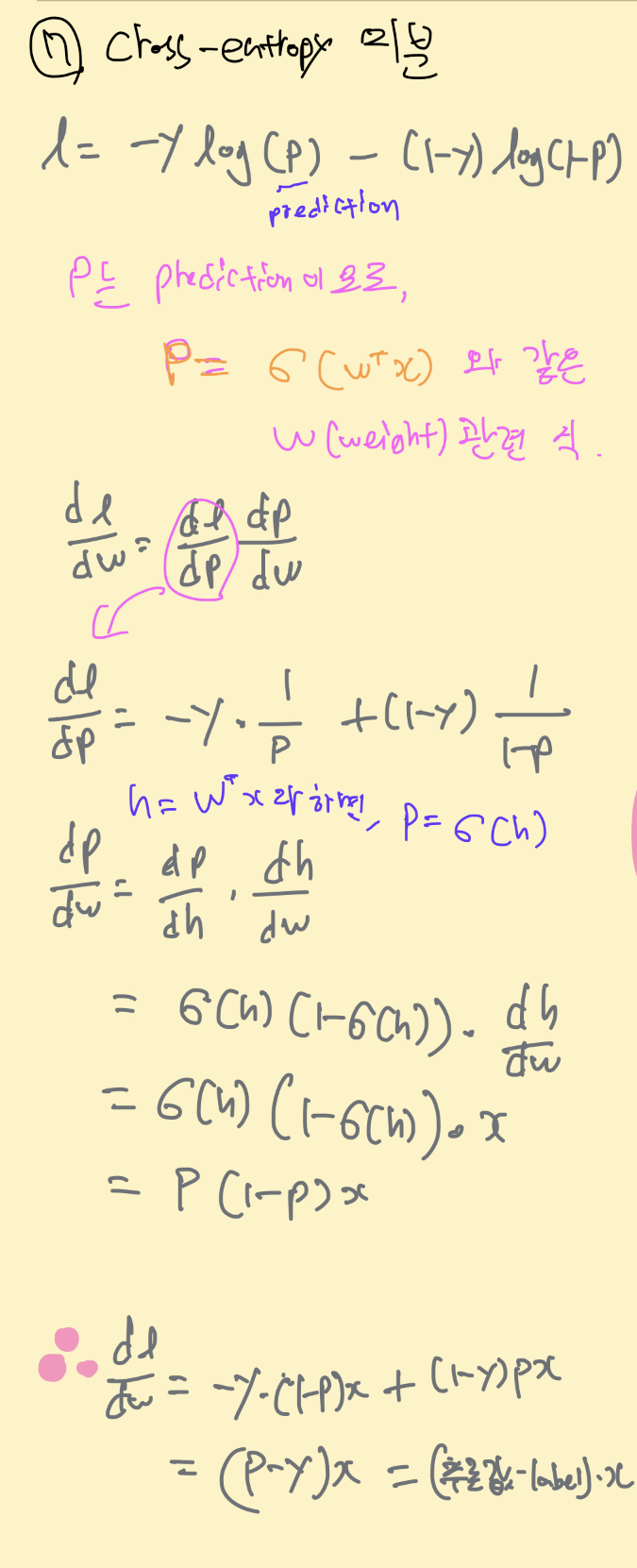

# cross-entropy 함수 형태와, sigmoid미분 :

'ML&DL' 카테고리의 다른 글

| 학부연구생 딥러닝 기본개념 학습내용 복습02 - Optimizer (0) | 2022.10.09 |

|---|---|

| 학부연구생 딥러닝 기본개념 학습내용 복습-01 순전파와 역전파&활성함수 (0) | 2022.10.09 |

| Hyperparameter 종류와 Tuning (0) | 2022.10.06 |

| SGD와 Weight Decay regularization (0) | 2022.10.06 |

| Softmax 함수의 사용과 미분 (1) | 2022.09.25 |